Cómo y por qué los microcontroladores pueden ayudar a democratizar el acceso a la IA de borde

Colaboración de Editores de DigiKey de América del Norte

2025-02-18

En los últimos años, la IA de borde ha ido ganando popularidad. Se espera que el mercado global asociado crezca a una tasa anual compuesta del 27.8% hasta 2035, aumentando hasta un valor neto de $356,840 millones.

Una variedad de factores impulsan esta demanda. El procesamiento de datos en el borde aborda las preocupaciones de seguridad que las empresas podrían tener sobre el envío de información confidencial o patentada a la nube. El procesamiento de borde también reduce la latencia, lo que puede ser importante en aplicaciones en tiempo real donde se deben tomar decisiones en fracciones de segundo. Los dispositivos de IoT industrial (IIoT) ofrecen operaciones basadas en datos, lo que a su vez aumenta los casos de uso de la IA de borde. Las implementaciones en rápida expansión (desde dispositivos médicos portátiles hasta dispositivos de vestir e IIoT) están impulsando el mercado de IA en el borde.

A medida que la tecnología crece en popularidad, existe una creciente demanda asociada de componentes que puedan manejar las necesidades de procesamiento de datos en sistemas integrados.

Las opciones de procesamiento informático: microcontroladores o microprocesadores

La gran mayoría de los dispositivos de IoT implementados hoy en día en equipos industriales y otros equipos integrados son dispositivos de bajo consumo con muy poca memoria. La potencia de procesamiento que tienen proviene de pequeños microcontroladores (MCU) integrados. Estas MCU tienen arquitecturas de bajo consumo que permiten que los sistemas integrados sean mucho más rentables que aquellos con microprocesadores.

Hasta la llegada de la IA de borde, las MCU satisfacían bien las necesidades de procesamiento de los dispositivos de IoT. Pero las MCU tradicionales generalmente no pueden brindar la potencia computacional necesaria para algoritmos de aprendizaje automático más complejos que son el sello distintivo de las aplicaciones de IA de borde. Estos algoritmos normalmente se ejecutan en unidades de procesamiento gráfico (GPU) y microprocesadores que tienen más potencia de cálculo. Sin embargo, el uso de estos componentes tiene sus propios inconvenientes, incluida la cantidad de energía consumida. Los microprocesadores o GPU no son las soluciones más eficientes energéticamente. Como resultado, la computación de borde impulsada por microprocesador podría no ser la mejor opción para todas las aplicaciones de IA de borde, y los proveedores optan por confiar en las MCU.

Las MCU independientes son menos costosas que las GPU y los microprocesadores. Para escalar la IA de borde, existe una creciente necesidad de aprovechar las ventajas de las MCU (bajo costo y bajo consumo de energía) y al mismo tiempo aumentar la potencia computacional.

De hecho, a lo largo de los años, algunos factores han convergido para aumentar las capacidades de las MCU en el borde.

¿Qué está facilitando el uso de MCU en el borde?

Si bien la suposición general ha sido que la MCU tradicional es demasiado liviana para el procesamiento de datos relacionados con la IA, los cambios tanto en el diseño de la MCU como en el ecosistema tecnológico más amplio están impulsando su adopción en casos de uso de IA de borde.

Estos factores incluyen:

La integración de aceleradores de IA en MCU: cuando la MCU por sí sola tiene dificultades para satisfacer las demandas de computación de borde, su integración con un acelerador de IA/ML, como unidades de procesamiento neuronal (NPU) o procesadores de señales digitales (DSP), mejora el rendimiento.

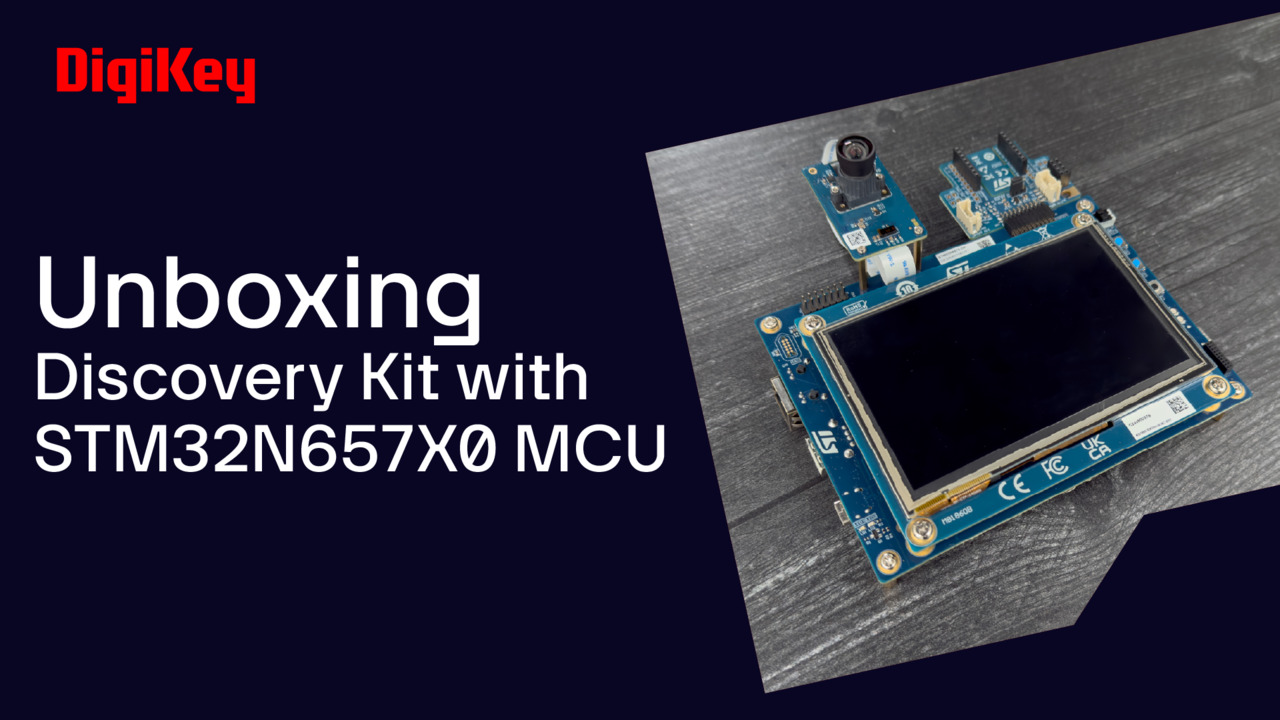

Por ejemplo, las unidades centrales de procesamiento (CPU) de la serie STM32N6 (Figura 1) de STMicroelectronics se basan en el Cortex-M55 Arm que funciona a 800 MHz. La tecnología de procesamiento vectorial Arm Helium lleva las capacidades de procesamiento DSP a una CPU estándar. La STM32N6 es la primera MCU STM32 que incorpora el acelerador ST Neural-ART, una NPU desarrollada internamente y diseñada para potentes aplicaciones de IA de borde.

Figura 1: La STM32N6 es la primera MCU STM32 que incorpora el acelerador ST Neural-ART, una unidad de procesamiento neuronal (NPU) desarrollada internamente y diseñada para aplicaciones de IA de borde con uso eficiente de la energía. (Fuente de la imagen: STMicroelectronics).

Figura 1: La STM32N6 es la primera MCU STM32 que incorpora el acelerador ST Neural-ART, una unidad de procesamiento neuronal (NPU) desarrollada internamente y diseñada para aplicaciones de IA de borde con uso eficiente de la energía. (Fuente de la imagen: STMicroelectronics).

- Modelos de IA optimizados para el borde: los algoritmos de aprendizaje automático e IA de alto rendimiento no pueden simplemente transferirse a las MCU. Deben optimizarse para recursos computacionales limitados. Las arquitecturas de IA compactas como TinyML y MobileNet hacen exactamente eso junto con técnicas de optimización, lo que permite que incluso las MCU en el borde ejecuten algoritmos de IA. STMicroelectronics lanzó STM32Cube.AI, una solución de software que convierte una red neuronal en código C optimizado para MCU STM32. El uso de la solución junto con la STM32N6 ayuda a garantizar el rendimiento necesario para las aplicaciones de IA de borde a pesar de las limitaciones de procesamiento y memoria.

El auge de los ecosistemas de IA: simplemente tener un componente de hardware capaz de realizar procesamiento relacionado con IA en el borde no es suficiente. La ejecución de algoritmos de IA en el borde requiere ecosistemas amigables para los desarrolladores que ayuden a facilitar las implementaciones de IA. Herramientas específicas como TensorFlow Lite para microcontroladores ayudan a ofrecer dichas soluciones. Las comunidades de código abierto como Hugging Face y otras plataformas ofrecen modelos previamente entrenados y bibliotecas de código que los desarrolladores pueden probar y adaptar para sus casos de uso específicos. Estos ecosistemas de IA reducen la barrera para la adopción de la tecnología y democratizan el acceso incluso para empresas con recursos limitados que tal vez no podrían desarrollar modelos de IA propios desde cero.

STMicroelectronics cuenta con un ecosistema de hardware y software específicamente diseñado, ST Edge AI Suite, para soluciones de IA de borde optimizadas. El paquete consolida muchas de las bibliotecas y herramientas de IA de ST para facilitar que los desarrolladores encuentren modelos, fuentes de datos, herramientas y compiladores que puedan generar código para el microcontrolador.

Los modelos previamente entrenados en un zoológico de modelos proporcionan un punto de partida para los desarrolladores. Estos modelos utilizan el formato Open Neural Network Exchange (ONNX), un estándar abierto para representar modelos de aprendizaje automático en áreas como visión computacional (CV), procesamiento del lenguaje natural (NLP), IA generativa (GenAI) y aprendizaje automático de gráficos.

- Códigos para estandarización e interoperabilidad: si bien los ecosistemas de IA han ayudado a las empresas a probar casos de uso de IA de borde, los formatos de modelos abiertos y estandarizados han facilitado una integración perfecta entre sistemas de hardware. La compatibilidad entre herramientas de software y MCU ha ayudado a reducir los obstáculos para las implementaciones de IA de borde.

- Atención a la seguridad en el borde: si bien las MCU eliminan o al menos disminuyen la necesidad de procesamiento de datos en la nube, los componentes de hardware brindan capas adicionales de seguridad. Por lo general, incluyen características como cifrado de hardware y arranque seguro, que protegen tanto los datos como los modelos de IA de actores maliciosos.

Características destacables del hardware de la STM32N6

La serie STM32N6 incluye una MCU de alto rendimiento con una NPU, un paquete de módulos de cámara y un kit de descubrimiento. La serie utiliza una arquitectura ARM Cortex-M típica y tiene varias características clave que hacen que estos dispositivos sean adecuados para la IA en el borde. Entre ellos se incluyen:

- Acelerador neural ART, que puede ejecutar modelos de redes neuronales. Está optimizado para algoritmos de IA intensivos, tiene una velocidad de reloj de 1 GHz y proporciona 600 GOPS con una eficiencia energética promedio de 3 TOPS/W.

- Soporte para instrucciones de extensión vectorial de perfil M (MPVE) “Helium”, un conjunto de instrucciones ARM que habilitan potentes funciones de redes neuronales y DSP. Estas instrucciones están diseñadas, por ejemplo, para trabajar con números de punto flotante de 16 y 32 bits, lo que les permite manipular eficientemente números de baja precisión. Estos son importantes para procesar modelos ML.

- ST Edge AI Suite, un repositorio de herramientas de software gratuito, casos de uso y documentación que ayuda a los desarrolladores de todos los niveles de experiencia a crear IA para el borde inteligente. El paquete también incluye herramientas como ST Edge AI Developer Cloud, que cuenta con redes neuronales dedicadas en el zoológico de modelos STM32, una granja de placas para evaluación comparativa del mundo real y más.

- Casi 300 unidades de acumulación múltiple configurables y dos buses de memoria AXI de 64 bits para un rendimiento de 600 GOPS.

- Procesador de señal de imagen (ISP) dedicado incorporado, que puede interactuar directamente con múltiples cámaras de 5 megapíxeles. Para construir sistemas que incorporen cámaras, los desarrolladores tienen que ajustar el ISP para un sensor de cámara semiconductor complementario de óxido metálico (CMOS) particular y su lente. El ajuste generalmente requiere experiencia especializada o ayuda de terceros. ST proporciona a los desarrolladores un software de escritorio especial llamado "iQTune" para este propósito. Este software, que se ejecuta en una estación de trabajo Linux, se comunica con el código integrado en la STM32 y analiza la precisión del color, la calidad de la imagen y las estadísticas, y configura los registros del ISP adecuadamente.

- Admite MIPI CSI-2, la interfaz de cámara más popular en aplicaciones móviles, sin necesidad de un ISP externo compatible con esta interfaz serial de cámara en particular.

- Muchas capacidades adicionales en un solo dispositivo significan que los desarrolladores ahora pueden ejecutar una red neuronal junto con una interfaz gráfica de usuario (GUI) sin tener que utilizar múltiples MCU.

- Seguridad sólida, incluidas certificaciones Target SESIP nivel 3 y PSA nivel 3.

Conclusión:

Las aplicaciones de aprendizaje automático que se ejecutaban en el borde solían necesitar microprocesadores de alto rendimiento en sistemas integrados para soportar la carga de ejecutar algoritmos complejos. Gracias a MCU potentes como las CPU de la serie STM33N6 de STMicroelectronics, las empresas ahora pueden democratizar la IA en el borde. STMicroelectronics ofrece un ecosistema completo para la implementación de IA en el borde, incluidos los componentes de software y hardware para la inferencia.

Descargo de responsabilidad: Las opiniones, creencias y puntos de vista expresados por los autores o participantes del foro de este sitio web no reflejan necesariamente las opiniones, las creencias y los puntos de vista de DigiKey o de las políticas oficiales de DigiKey.